اشتراک گذاری

الگوریتم گوگل چیست؟ معرفی ۲۲ الگوریتم گوگل

گوگل به عنوان یکی از مطرحترین موتورهای جستجو که هدف اصلی آن جلب رضایت کاربران است، الگوریتمهای مختلفی دارد که وظیفه اصلی آنها بهینهسازی نتایج گوگل است. هر یک از این الگوریتمها برای هدف خاصی طراحی شدهاند، اما در کل، هدف همه آنها ارائه مرتبطترین و مفیدترین وبسایتها به کاربرانی است که در جستجوی اطلاعات، محصولات یا خدمات آنلاین هستند.

با درک نحوه عملکرد الگوریتم، کسب و کارهای اینترنتی میتوانند تغییرات لازم را در سایتهای خود ایجاد کنند تا رتبه سایت را در صفحه نتایج جستجوی گوگل بهبود بخشند و ترافیک سایت و مشتریان بالقوه آنها افزایش یابند. در ادامه به اهمیت الگوریتم گوگل و معرفی کامل آنها پرداختهایم:

الگوریتم گوگل چیست؟

الگوریتم گوگل مجموعه پیچیدهای از قوانین و فرآیندهایی است که برای بازیابی دادهها از فهرست جستجو و ارائه فوری بهترین نتایج ممکن برای یک عبارت جستجو شده استفاده میشود. موتور جستجو از ترکیبی از الگوریتمها و فاکتورهای رتبهبندی متعدد برای تعیین ارتباط و رتبهبندی صفحات سایت در صفحات نتایج موتورهای جستجو (SERP) استفاده میکند.

الگوریتم گوگل هنگام رتبهبندی صفحات وب فاکتورهای مختلفی از جمله کلمات کلیدی، بکلینکها، سرعت بارگذاری صفحه، سازگاری با موبایل، کیفیت محتوا، تجربهکاربری و موارد دیگر را در نظر میگیرد. با تجزیه و تحلیل و ارزیابی این عوامل، گوگل تعیین میکند که کدام صفحات وب مرتبطترین و معتبرترین برای یک عبارت جستجو شده معین هستند و آنها را در SERPها به ترتیب مرتبط بودن و مفید بودنشان نمایش میدهد.

الگوریتم گوگل چه اهمیتی دارد؟

هدف اصلی گوگل ارائه دقیقترین و مفیدترین نتایج جستجو به کاربر است و الگوریتم گوگل نقش مهمی در ارائه محتوای با کیفیت به کاربران در صفحه نتایج جستجو دارد. این امر گوگل را به محبوبترین موتور جستجو در جهان تبدیل کرده است و کسب و کارها و سایتها را قادر میسازد تا با بهینهسازی محتوای سایت خود و رعایت بهترین اصول سئو به مخاطبان بیشتری دست یابند. برخی از دلایل اهمیت الگوریتم گوگل موارد زیر است:

۱.نتایج جستجوی مرتبط: هدف اصلی الگوریتم گوگل ارائه مرتبطترین و مفیدترین نتایج جستجوی کاربران براساس درخواست آنها است. به این معنی که وقتی از گوگل برای جستجوی اطلاعات، محصولات یا خدمات استفاده میکنید، به احتمال زیاد آنچه را که به دنبالش هستید سریع و آسان پیدا میکنید.

۲.تجربه کاربری بهتر: الگوریتم گوگل عوامل مختلفی را که بر تجربه کاربر تأثیر میگذارند در نظر میگیرد، مانند سرعت بارگذاری صفحه، سازگاری با موبایل و کیفیت محتوا. با رتبهبندی صفحات وب بر اساس این عوامل، گوگل تضمین میکند که کاربران در هنگام مرور وب تجربه مثبتی دارند.

۳.رقابت منصفانه: الگوریتم گوگل شرایط را برای کسب و کارها و سایتهایی که میخواهند در SERP رتبه خوبی داشته باشند، فراهم میکند. با ارزیابی سایتها بر اساس عوامل مختلف، از جمله ارتباط و اعتبار، گوگل تضمین میکند که بهترین محتوا بدون توجه به اندازه یا بودجه وبسایت، به رتبههای بالاتری دست مییابد.

۴.محتوای با کیفیت: الگوریتم گوگل ارزش بالایی برای محتوایی قائل است که ارزشی را برای کاربران ایجاد میکند. به این معنی که سایتهایی که برای تولید محتوای با کیفیت بالا سرمایهگذاری میکنند، احتمالاً در رتبهبندی SERP قرار میگیرند، که باعث ایجاد محتوای با کیفیت بیشتر در سراسر وب میشود.

معرفی الگوریتمهای گوگل

توجه به این نکته ضروری است که الگوریتمهای گوگل دائما در حال تغییر و تحول هستند. گوگل چندین بار در سال الگوریتم خود را به روز میکند و این بهروزرسانیها ممکن است تاثیر قابل توجهی بر رتبه سایت داشته باشند. برخی بهروزرسانیها ممکن است فاکتورهای رتبهبندی جدیدی را معرفی کنند یا وزن جدیدی برای فاکتورهای موجود در نظر بگیرند، یا ممکن است انواع خاصی از سایتها یا اقداماتی را که هرزنامه یا اسپم تلقی میشوند هدف قرار دهند. در ادامه به معرفی این الگوریتمها پرداختهایم:

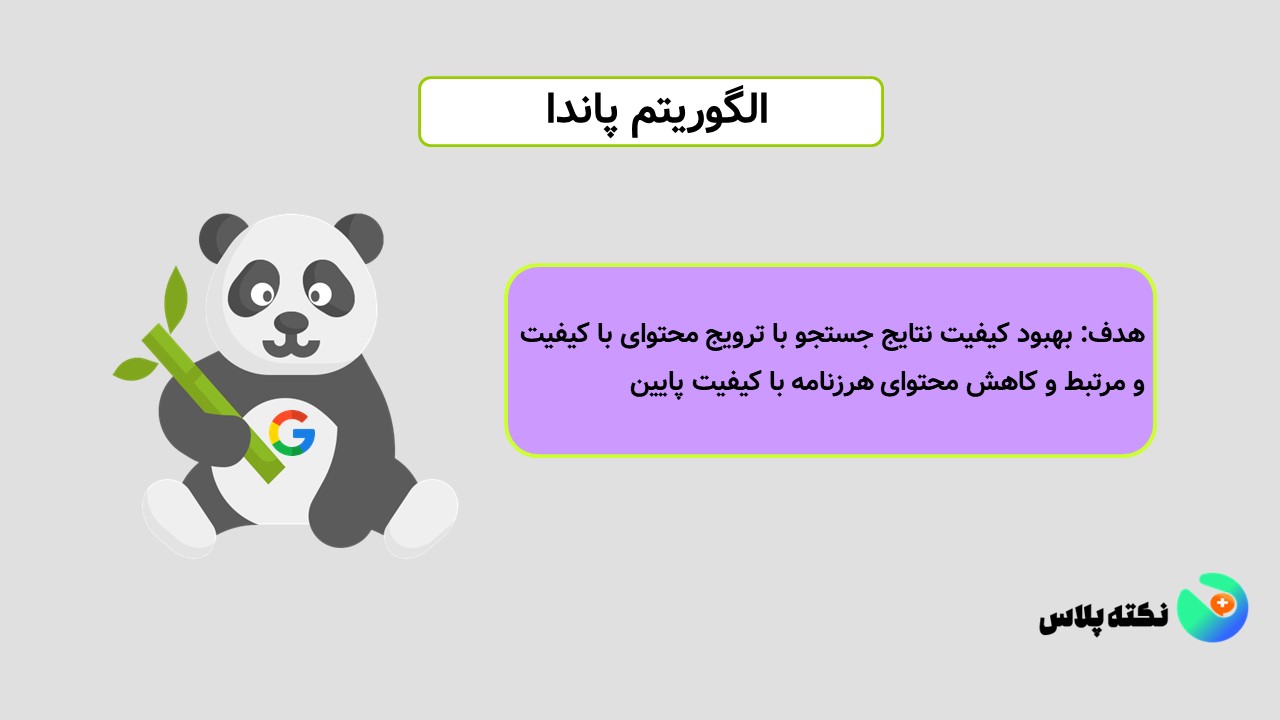

الگوریتم پاندا(Panda Algorithm)

الگوریتم پاندا تلاش گوگل برای حذف تکنیکهای سئو کلاه سیاه و هرزنامهها است. هدف اصلی این الگوریتم بررسی کیفیت محتوا، کاهش رتبه سایتهایی که محتوای بیکیفیت دارند و شناسایی میزان رضایت کاربران از متن قرار گرفته در صفحه است. براساس این الگوریتم سایتهایی که ارزش پایینی برای کاربران دارند، محتوای سایتهای دیگر را کپی میکنند یا سایتهایی که خیلی مفید نیستند، رتبه آنها در نتایج گوگل کاهش مییابد. بنابراین بهتر است از محتوای یونیک استفاده کنید و حجم مناسبی از نظر تعداد کلمات و لینک را در سایت خود لحاظ کنید.

الگوریتم پاندا بر اساس عواملی مانند میزان و کیفیت محتوا، تجربه کاربر، سرعت صفحه و قدرت کلی وبسایت، امتیاز کیفیت را به صفحات وب اختصاص میدهد. صفحاتی که محتوای کم کیفیت، محتوای تکراری یا تبلیغات بیش از حد دارند، کیفیت پایینتری دارند و ممکن است از نتایج جستجو رتبه پایینتری به دست آورند یا حذف شوند.

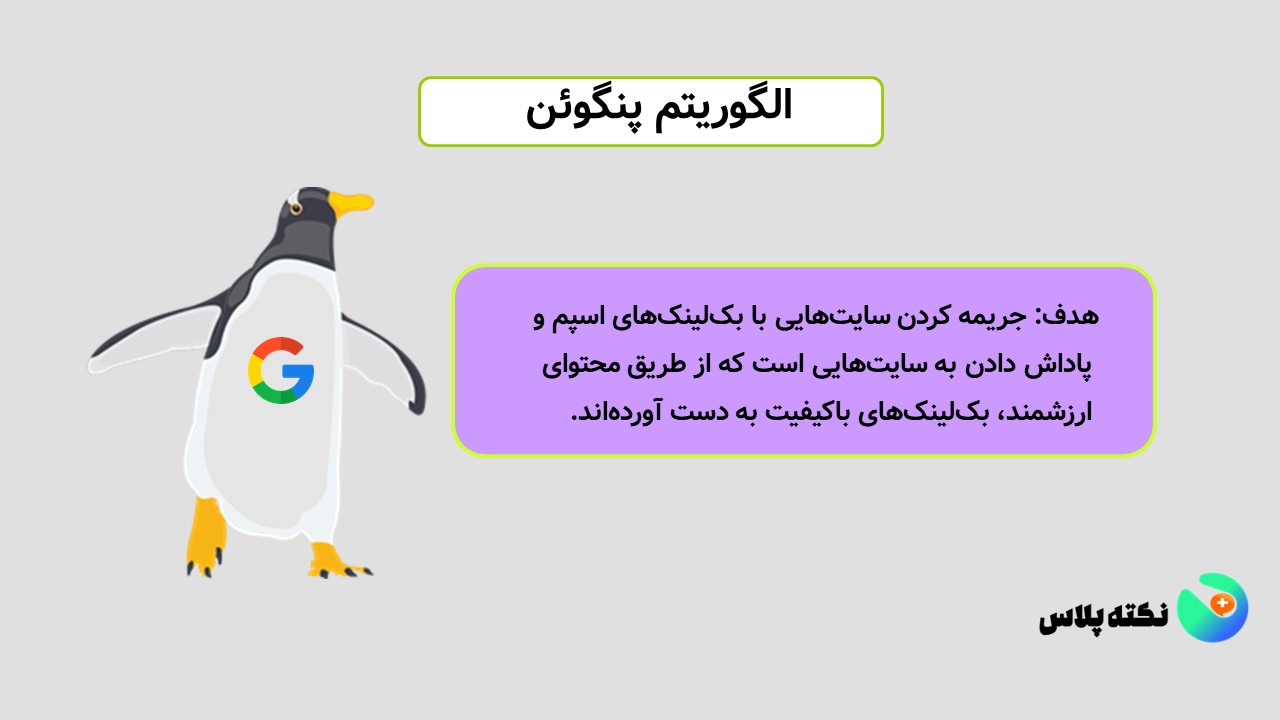

الگوریتم پنگوئن(Penguin Algorithm)

الگوریتم پنگوئن بهروزرسانی الگوریتم جستجوی گوگل است که بر شناسایی و جریمه کردن سایتهایی تمرکز دارد که به ساخت بکلینکهای اسپم یا سایر روشهای دستکاری برای افزایش غیرطبیعی رتبه خود در صفحات نتایج جستجو اقدام میکنند. این شیوهها شامل خرید لینک، شرکت در مزارع لینک یا استفاده از ابزارهای لینکسازی خودکار است. سایتهایی که از این شیوهها استفاده میکنند ممکن است توسط اگوریتم پنگوئن جریمه شوند، که منجر به کاهش رتبه سایت یا حتی حذف از صفحه نتایج جستجو میشود.

هدف الگوریتم پنگوئن بهبود کیفیت نتایج جستجو با تبلیغ سایتهایی است که از شیوههای سئو کلاه سفید استفاده میکنند. این الگوریتم صاحبان سایت را تشویق میکند تا بر ایجاد پیوندهای با کیفیت بالا و مرتبط از طریق روشهای طبیعی، مانند ایجاد محتوای ارزشمند و تعامل با مخاطبان خود تمرکز کنند.

الگوریتم تازگی محتوا(Freshness Algorithm)

تازگی محتوا یک الگوریتم خاص مورد استفاده گوگل نیست، بلکه مفهومی است که به اهمیت به روز و مرتبط نگه داشتن محتوای سایت اشاره دارد. در حالی که گوگل از الگوریتمهای مختلفی برای تعیین رتبهبندی جستجو استفاده میکند، تازگی محتوا عاملی است که در برخی موارد میتواند بر رتبهبندی جستجو تأثیر بگذارد.

به طور کلی، موتورهای جستجو محتوای تازه و مرتبط را بر محتوای قدیمی ترجیح میدهند. سایتهایی که اطلاعات جدید و مفید به کاربران خود ارائه میدهند احتمالاً در نتایج جستجو رتبه خوبی دارند. از سوی دیگر، سایتهایی که محتوای قدیمی دارند ممکن است در رتبهبندی جستجو جریمه شوند.

الگوریتمهای گوگل هنگام ارزیابی تازگی محتوا، عوامل مختلفی از جمله تعداد دفعات بهروزرسانی، نوع محتوا و ارتباط بروز رسانیها با موضوع کلی سایت را در نظر میگیرند. به عنوان مثال، وبسایتهای خبری که اخبار روز را پوشش میدهند، معمولاً باید محتوای خود را بیشتر از وبلاگی که بر یک موضوع خاص متمرکز است، بهروزرسانی انجام دهند.

الگوریتم رقص گوگل(Google Dance Algorithm)

رقص گوگل اصطلاحی است مربوط به زمانی که گوگل در طی چند روز، رتبه صفحات را در صفحات نتایج جستجوی گوگل جابجا میکند تا رفتار کاربران را نسبت به آن بسنجد. رقص گوگل اغلب مربوط به سایتها و صفحات جدید است. این تغییرات ناگهانی برای بررسی نحوه واکنش کاربران به یک سایت انجام میشود. اگر CTR، میانگین زمان صرف شده در یک سایت بالا و نرخ پرش پایین باشد، سایت رتبه خوبی به دست میآورد. در این روش گوگل سعی میکند سایتها را به درستی ارزیابی و رتبهبندی کند.

الگوریتم فِرِد(Fred Algorithm)

گوگل فرد یک نام غیر رسمی است که به یک بهروزرسانی الگوریتم اصلی که گوگل در مارس ۲۰۱۷ منتشر کرد داده شده است. نام رسمی این بهروزرسانی توسط گوگل فاش نشده است، اما به طور گسترده اعتقاد بر این است که مربوط به بهبود کیفیت محتوا در وبسایتها بوده است.

بهروزرسانی الگوریتم فرد وبسایتهایی را هدف قرار میدهد که به نظر میرسید محتوای با کیفیت پایینی دارند، به ویژه آنهایی که برای ایجاد درآمد به تبلیغات یا افیلیت مارکتینگ متکی بودند. چنین سایتهایی اغلب محتوای مفید کمی داشتند و در درجه اول برای هدایت ترافیک به سایتهای دیگر طراحی شده بودند. بهروزرسانی الگوریتم فِرد باعث کاهش قابل توجهی در رتبهبندی و ترافیک بسیاری از سایتهایی شد که تحت تأثیر قرار گرفتند.

این الگوریتم در کنار الگوریتم E-A-T قصد دارد نتایج باکیفیتتری را در اختیار کاربران قرار دهد. در اصل الگوریتم فِرد به سایتهایی که شرایط زیر را دارند، رتبههای پایینتری اختصاص میدهد:

• تبلیغات بیش از حد

• تولید محتواهای کوتاه

• کیفیت لینک پایین

• محتواهای بیکیفیت

• تعداد زیادی لینک افیلیت

• عدم تعامل مخاطبان با محتوا

الگوریتم گورخر(Zebra Algorithm)

الگوریتم گورخر که در سال ۲۰۱۳ معرفی شد و هدف از طراحی این الگوریتم شناسایی سایتهای فروشگاهی نامعتبر و جلوگیری از کلاهبرداری آنها از کاربران و خریداران بوده است. امروزه با افزایش فروشگاههای اینترنتی، اکثر مردم خرید خود را از طریق اینترنت انجام میدهند. بنابراین گوگل با کمک این الگوریتم اعتماد کاربران خود را حفظ میکند.

الگوریتم دزد دریایی(Pirate Algorithm)

الگوریتم دزد دریایی که در سال ۲۰۱۲ با هدف کاهش رتبه سایتهایی که قوانین کپی رایت را نقض میکنند معرفی شد. این اقدام برای محافظت از مالکیت معنوی سازندگان و جلوگیری از انتشار محتوای غیرقانونی است که میتواند به کسب درآمد صاحبان اثر آسیب برساند. هدف گوگل از پیادهسازی این الگوریتم تلاش برای اطمینان از کیفیت بالا و مرتبط بودن نتایج جستجوی آن برای کاربران، ایجاد شرایط منصفانهتر برای همه وبسایتها و جلوگیری از دزدی آنلاین است.

الگوریتم مرغ مگس خوار(Hummingbird Algorithm)

مرغ مگس خوار یک الگوریتم جستجوی مورد استفاده توسط گوگل است که در سال ۲۰۱۳ معرفی شد. این الگوریتم برای درک معانی و مفهوم کلمات در یک عبارت جستجو و ارائه نتایج جستجوی دقیقتر و مرتبطتر طراحی شده است.

این الگوریتم به جای تطبیق تک تک واژگان در کوئری با واژگان در نتایج جستجو، بر درک معنای کوئری و تطبیق آن با نتایج مرتبط تمرکز میکند و میتواند کوئریهای پیچیده و طولانی را تفسیر کند و نتایج مرتبطتری ارائه دهد که با هدف کاربر مطابقت دارد.

به عنوان مثال قبل از این الگوریتم با جستجوی عبارت” پرداخت آنلاین قبض از طریق بانک ملت” صفحه اصلی بانک در نتایج جستجو نمایش داده میشد اما بعد از این الگوریتم لینک صفحه مربوط به پرداخت قبوض مستقیماً در صفحه جستجوی گوگل نمایش داده میشود.

الگوریتم رنک برِین(Rank Brain Algorithm)

الگوریتم رنک برین یک الگوریتم یادگیری ماشینی است که از هوش مصنوعی برای تفسیر و پردازش کوئریهای جستجو به روشی شبیه انسان استفاده میکند. این الگوریتم از تکنیکهای هوش مصنوعی و یادگیری ماشین برای تجزیه و تحلیل سوالات جستجو و درک زمینه و معنای آنها استفاده میکند. سپس میتواند از این اطلاعات برای تطبیق بهتر کوئری با صفحات مرتبط در وب استفاده کند، حتی اگر کلمات کلیدی دقیق مورد استفاده در کوئری در آن صفحات وجود نداشته باشد.

با بهبود ارتباط نتایج جستجو، الگوریتم رنک برین به بهبود کیفیت کلی موتور جستجوی Google و ارائه تجربه کاربری بهتر به کاربران کمک میکند.

الگوریتم کبوتر(Pigeon Algorithm)

الگوریتم کبوتر یک الگوریتم جستجوی مورد استفاده توسط گوگل است که در سال ۲۰۱۴ معرفی شد. هدف آن ارائه نتایج جستجوی محلی مرتبطتر و دقیقتر با استفاده از مکان و فاصله به عنوان عوامل رتبهبندی است.

این الگوریتم بر بهبود رتبهبندی نتایج جستجوی محلی، مانند جستجو برای مشاغل یا خدمات محلی تمرکز دارد. از دادههای لوکیشن برای ارائه نتایج دقیقتری که به مکان فیزیکی کاربر نزدیکتر است استفاده میکند و مشاغلی که در نزدیکی کاربر قرار دارند، بیشتر در صفحه نتایج جستجو ظاهر میشوند.

کبوتر فاکتورهای دیگری را نیز در نظر می گیرد، مانند ارتباط جستجوی جستجو با موقعیت مکانی کاربر و کیفیت و اعتبار وب سایت کسب و کار. این کمک می کند تا اطمینان حاصل شود که نتایج نه تنها از نظر جغرافیایی مرتبط هستند، بلکه برای کاربر مفید و آموزنده هستند.

به طور کلی، الگوریتم کبوتر برای ارائه تجربه جستجوی بهتری برای کاربرانی که به دنبال مشاغل یا خدمات محلی هستند طراحی شده است. کسبوکارها را تشویق میکند تا روی بهینهسازی وبسایتهایشان برای جستجوی محلی تمرکز کنند و اطمینان حاصل کنند که دادههای مکانشان دقیق و بهروز است.

الگوریتم موش کور(Possum Algorithm)

الگوریتم موش کور یا Possum الگوریتم بهینهسازی است که از رفتار موشهای کور در جستجوی غذا در محیط اطرافشان الهام گرفته شده است. هدف آن بهبود دقت و ارتباط نتایج جستجوی محلی است. این الگوریتم بر فیلتر کردن محتوای تکراری و فهرستهای هرزنامه از نتایج جستجوی محلی متمرکز است و فقط مرتبطترین و باکیفیتترین نتایج را به کاربران نشان میدهد.

الگوریتم موش کور با هدف ارائه نتایج دقیقتری بر اساس موقعیت مکانی کاربر و هدف جستجوی او میباشد. به این معنی که کسب و کارهای محلی که به موقعیت مکانی کاربر نزدیکتر هستند و بیشتر به جستجوی آنها مرتبط هستند، در نتایج جستجو اولویت بیشتری خواهند داشت.

الگوریتم بِرت(Bert Algorithm)

برت الگوریتمی است که برای درک بهتر زبان طبیعی مورد استفاده در کوئریها استفاده میشود. یک الگوریتم یادگیری عمیق مبتنی بر معماری ترانسفورماتور است که بر روی مقادیر زیادی از دادههای متنی آموزش داده شده است.

این الگوریتم برای درک زمینه و تفاوتهای ظریف زبان، از جمله معنای تک تک کلمات و نحوه ارتباط آنها با یکدیگر در یک جمله طراحی شده است و به گوگل کمک میکند تا کوئریهای جستجو را بهتر با صفحات مرتبط در وب مطابقت دهد، حتی اگر کوئری حاوی زبان پیچیده یا مبهم باشد.

یکی از ویژگی های کلیدی الگوریتم برت توانایی آن در درک معنای حروف اضافه مانند “به”، “برای” و “با” است که میتواند به طور قابل توجهی بر معنای جمله تأثیر بگذارد. با درک متن این کلمات، برت قادر است نتایج جستجوی دقیقتری ارائه دهد.

الگوریتم Page lay out

الگوریتم پیج لی اوت الگوریتمی است که برای جریمه کردن سایتهایی که از تبلیغات بیش از حد نسبت محتوا در بالای صفحه(بخشی از صفحه وب که بدون پیمایش قابل مشاهده است) استفاده میکنند.

هدف این الگوریتم بهبود تجربه کاربر با اولویتبندی سایتهایی است که محتوای باکیفیت و تجربه کاربری خوب ارائه میدهند. وبسایتهایی که تبلیغات بیش از حد یا محتوای کمی در بالای صفحه دارند، ممکن است توسط الگوریتم جریمه شوند و رتبه خود را از دست دهند.

الگوریتم Payday

الگوریتم Payday در سال ۲۰۱۳ به منظور حذف سایتهای هرزنامه و با کیفیت پایین از صفحات نتایج جستجو برای کوئریهای مربوط به خدمات مالی، پورنوگرافی و سایر عبارتهای اسپم معرفی شد. هدف این الگوریتم بهبود کیفیت نتایج جستجو برای کاربران با کاهش نمایش وبسایتهای هرزنامه و بیکیفیت است.

الگوریتم کافئین(Caffeine Algorithm)

الگوریتم کافئین توسط گوگل در سال ۲۰۱۰ معرفی شد و هدف آن بهبود سرعت و کارایی موتور جستجوی گوگل بود. الگوریتم کافئین یک بهروزرسانی بزرگ برای سیستم ایندکس گوگل بود که به موتور جستجو اجازه میداد تا صفحات وب را سریعتر و در زمان واقعیتر کراول و ایندکس کند.

کافئین همچنین برای بهبود رتبهبندی محتوای تازهتر، مانند اخبار فوری یا رویدادهای اخیر طراحی شده است. وقتی کاربران موضوعی را جستجو میکنند، احتمالاً مرتبطترین و جدیدترین محتوا را در بالای نتایج جستجو میبینند. به طور کلی، هدف این الگوریتم ارائه تجربه جستجوی سریعتر و دقیقتری برای کاربران است.

الگوریتم Mobilegeddon

الگوریتم Mobilegeddon در سال ۲۰۱۵ برای بهبود تجربه جستجو برای کاربران در دستگاههای تلفن همراه با اولویتبندی صفحات سازگار با موبایل در نتایج جستجو طراحی شده است. این الگوریتم بر جستجوهای تلفن همراه تأثیر میگذارد و رتبه سایتهایی که سازگار با موبایل یا واکنشگرا نیستند، در نتایج جستجوی تلفن همراه کاهش مییابد.

الگوریتم MUM

الگوریتم MUM(Multitask Unified Model) الگوریتم جدیدی است که توسط گوگل در سال ۲۰۲۱ معرفی شد. MUM یک مدل هوش مصنوعی در مقیاس بزرگ است که برای بهبود دقت و جامعیت نتایج جستجو طراحی شده است. هدف پاسخگویی به نیازهای جستجوی با استفاده از الگوریتم مبتنی بر هوش مصنوعی برای بهبود قابلیت جستجوی آنلاین است.

با کمک این الگوریتم دیگر نیازی به انجام چندین جستجو برای مقایسه و به دست آوردن بینش عمیقتر در مورد موضوع را از بین میبرد. این الگوریتم توانایی درک و ارائه راهحلهایی را دارد که نه تنها بر اساس محتوای متنی، بلکه بر اساس تفسیر تصاویر، ویدیوها و پادکستها به روشی که قبلاً هرگز امکانپذیر نبوده است.

الگوریتم Mobile First Index

این الگوریتم جستجوی گوگل که در سال ۲۰۱۸ معرفی شد، در درجه اول بر روی نسخه موبایل یک سایت تمرکز دارد و از آن به عنوان نسخه اولیه برای اهداف ایندکس و رتبه بندی استفاده میکند. با افزایش محبوبیت دستگاههای تلفن همراه برای جستجو در اینترنت، گوگل تمرکز خود را به نسخه موبایل سایتها معطوف کرده است.

با الگوریتم Mobile First Index، گوگل نسخه موبایل یک وبسایت را برای تعیین ارتباط و رتبه آن در نتایج جستجو ارزیابی میکند و سایتهایی که سازگار با موبایل هستند و تجربه کاربری خوبی را در دستگاههای تلفن همراه ارائه میدهند، احتمالاً در نتایج جستجو رتبه بالاتری دارند.

الگوریتم E-A-T

این الگوریتم به مجموعهای از دستورالعملهای کیفی اشاره دارد که گوگل برای ارزیابی محتوا و اعتبار سایتها از آنها استفاده میکند. E-A-T بلکه مجموعهای از معیارهایی است که الگوریتمهای گوگل برای رتبهبندی وبسایتها استفاده میکنند.

دستورالعملهای E-A-T به ویژه برای وبسایتهایی که مشاوره بهداشتی، مالی، یا حقوقی ارائه میدهند، و همچنین سایتهای خبری و سایر سایتهایی که هدفشان اطلاعرسانی یا آموزش کاربران است، مرتبط است. این نوع سایتها میتوانند تاثیر قابل توجهی بر زندگی کاربران داشته باشند و به همین دلیل، گوگل میخواهد اطمینان حاصل کند که آنها اطلاعات دقیق و قابل اعتمادی را ارائه میدهند.

E-A-T مخفف Expertise, Authority, Trustworthiness است:

Expertise (تخصص) به دانش و مهارتهای تولیدکننده محتوا یا صاحب وبسایت اشاره دارد. گوگل به این توجه میکند که محتوا توسط متخصصان در زمینه مربوطه ایجاد شده است.

Authority (اعتبار ) به شهرت و نفوذ تولیدکننده محتوا یا صاحب سایت اشاره دارد. گوگل به این توجه میکند که این سایت در صنعت شهرت زیادی دارد و به عنوان یک منبع اطلاعاتی قابل اعتماد دیده میشود.

Trustworthiness (قابل اعتماد بودن) به اعتبار و قابل اعتماد بودن محتوا اشاره دارد. گوگل به این توجه میکند که سایت اطلاعات دقیق و بیطرفانه ارائه میدهد و درگیر اقدامات گمراهکننده یا فریبنده نمیشود.

الگوریتم EMD

الگوریتمEMD(Exact Match Domain) الگوریتم جستجوی گوگل است که در سپتامبر ۲۰۱۲ معرفی شد. این الگوریتم سایتهایی که کیفیت پایینی دارند و برای کسب رتبه بالاتر در نتایج جستجو از نام دامنهای استفاده میکنند که دقیقاً با عبارت جستجوی شده توسط کاربر مطابقت دارد(به عنوان مثال برای سایتی در زمینه آموزش سئو انتخاب نام دامنه SEOTraining ) را هدف قرار میدهد.

در گذشته، چنین سایتهایی میتوانستند فقط به دلیل نام دامنه خود در نتایج جستجو رتبه بالاتری داشته باشند، حتی اگر محتوای آنها کیفیت پایینی داشت. اما در حال حاضر الگوریتم EMD این سایتهای با کیفیت پایین را با کاهش رتبه آنها در نتایج جستجو هدف قرار میدهد. این الگوریتم کیفیت و ارتباط محتوای وبسایت و همچنین کیفیت و ارتباط نام دامنه را ارزیابی میکند.

الگوریتم ونیز (Venice Algorithm)

الگوریتم ونیز الگوریتم جستجوی گوگل است که در سال ۲۰۱۲ معرفی شد. هدف این الگوریتم ارائه نتایج جستجوی محلی بیشتر برای کاربران با استفاده از موقعیت مکانی کاربر برای تأثیرگذاری بر نتایج جستجو است. این الگوریتم میتواند موقعیت مکانی بازدیدکنندگان را با آدرس IP آنها دریافت کند و وقتی یک عبارت را جستجو میکنید، نتایج محلی نزدیک به موقعیت مکانی شما را نشان میدهد، چه مکان خود را تنظیم کنید یا نه.

با الگوریتم ونیز، گوگل موقعیت مکانی کاربر را ارزیابی میکند و از این اطلاعات برای ارائه نتایج جستجوی مرتبط با منطقه محلی آنها استفاده میکند. به عنوان مثال، اگر کاربری در شهر شیراز عبارت “پیتزا” را جستجو کند، صفحه نتایج جستجو مکان فست فودها در شهر شیراز را به جای سایر نقاط جهان نشان میدهد.

الگوریتم مدیک یا طبی( Google Medic Algoithm)

الگوریتم Google Medic برای بهبود کیفیت و ارتباط نتایج جستجو، بهویژه در حوزه سلامت و تندرستی طراحی شده است. این بهروزرسانی بر ارزیابی تخصص، اعتبار و قابل اعتماد بودن سایتهایی که اطلاعاتی در مورد مسائل بهداشتی،سلامتی، پزشکی و موضوعات مرتبط ارائه میدهند، متمرکز است.

هدف الگوریتم گوگل مدیک این است که کاربرانی که در جستجوی اطلاعات مرتبط با سلامت هستند، منابع قابل اعتمادی را پیدا کنند و سایتهای بیکیفیت یا غیرقابل اعتمادی را که ممکن است قبلاً در نتایج جستجو نمایش داده شدهاند حذف کند. این امر به ویژه با توجه به آسیب احتمالی که اطلاعات بهداشتی نادرست یا گمراه کننده میتواند ایجاد کند بسیار مهم بود.

سوالات متداول

الگوریتم گوگل چیست؟

الگوریتم گوگل مجموعه پیچیدهای از قوانین ریاضی است که گوگل برای تعیین ارتباط، اعتبار و کیفیت صفحات وب و رتبهبندی آنها در صفحات نتایج موتورهای جستجو استفاده میکند. گوگل الگوریتمهای خود را مرتباً بهروزرسانی میکند تا دقت و ارتباط نتایج جستجوی خود را بهبود بخشد.

مهمترین الگوریتمهای گوگل کدامند؟

آخرین مطالب

نکته پلاس

هدف از راه اندازی سایت نکته پلاس ارائه مطالب کاملاً رایگان از منابع معتبر برای علاقمندان به دیجیتال مارکتینگ است.